Matematik

estimator

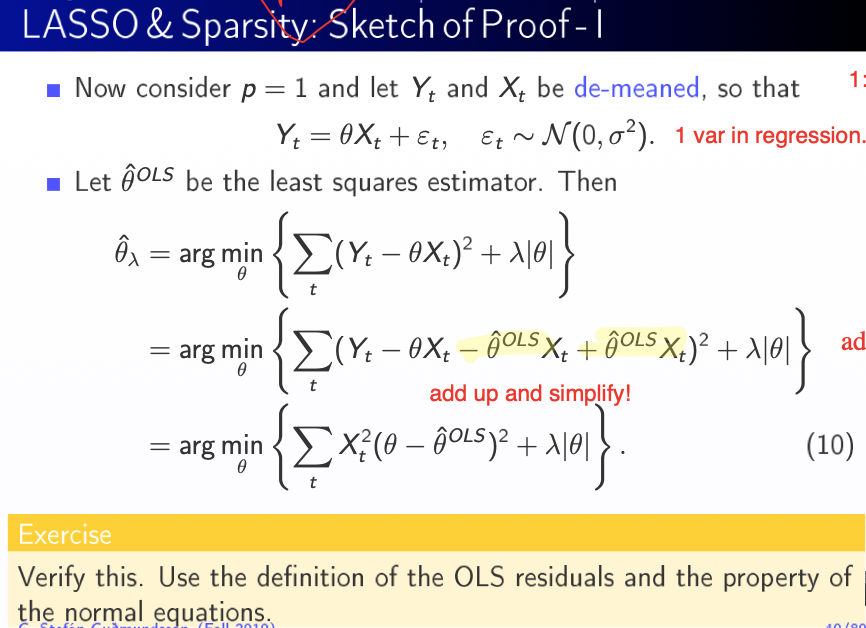

Nogen som kan verify dette? synes ikke jeg kan få det til at passe...

Svar #1

06. december 2019 af bokaj123

det der sker i lign 2 er bare at man plusser og minusser med ols estimatoren..

Svar #3

06. december 2019 af delc

For at minimere dette i forhold the skal vi blot minimere

Fra normal ligningerne opfylder :

.

Svar #4

06. december 2019 af bokaj123

tak for svaret delc, men i den første lign mangler du ikke X efter det første teta og + lambda i stedet for minus? kan du måske sætte lidt flere ord på, har lidt problemer med at følge dig i den udledning.

Svar #6

06. december 2019 af bokaj123

ser ud til at du deler den kvadrerede sum op så det første led ligner OLS og så en sum imellem som er noget fra det lille "trick" med plus minus teta og det sidste er det dobbelte produkt. Jeg vil sådan set bare gerne frem til lign (10) fra billedet :) kan jeg få tankerne bag din udledning?:) på forhånd tak for hjælpen

#3 kan se du rettede lambda, men mangler stadig et "x" foran det første teta :)

Svar #7

06. december 2019 af delc

Godt set. Den første led afhænger faktisk også af , men

som vi kender fra OLS minimerer denne.

Jeg nåede ikke at rette X, men der skulle være en der. Jeg var lidt for hurtigt med at skrive ligningerne ind. :)

Svar #8

06. december 2019 af bokaj123

Okay, men kan ikke helt se lign (10) fra billedet, og kan stadig ikke helt følge din udledning :(

Svar #9

06. december 2019 af delc

Da vi blot skal minimere ligning nr. 2 i mit svar og den midteste led er 0 får du (10) i dit billede

Svar #11

06. december 2019 af delc

Per definition af er

minimalt og

der for kan vi droppe den første og anden sidste led i argmin og så får du (10).

Svar #12

07. december 2019 af bokaj123

1) ∑(Y-θhatX)X = 0 hvor kommer det fra? skal lige være sikker arg min betyder vel bare at man finder minimum af argumentet første del af #11

2) og hvorfor forsvinder Σ(Y-θhatX)2 (første led) ?

Svar #13

07. december 2019 af delc

2) Den er minimalt for alle teta.

Svar #14

07. december 2019 af bokaj123

1) normal ligningen, tror ikke jeg har hørt det før, teta hat OLS findes ved at minimere de kvadrerede residualer.

2) Σ(Y-θhatX)2 forsvinder fordi den er minimalt for alle teta, det er somom der er et eller andet jeg ikke helt forstår ... måske kan du forklare hvorfor 2 og 4 led i #11 ikke forsvinder så?

Svar #15

07. december 2019 af bokaj123

1 led er per def = 0 OLS (minder lidt om 3 led men så alligevel ikke det den ikke er opløftet .....

2 led er det vi gerne vil vise og ændre sig ikke (men hvorfor sætter vi ikke bare det = 0 som led 3?

3 det eneste jeg ikke helt forstår er dett : ∑(Y-θhatX)X = 0

4 led er lambda er ok

Svar #16

07. december 2019 af bokaj123

du skriver "fra normal ligningen" opfylder ∑(Y-θhatX)X = 0 hvad vil det sige?

Svar #17

07. december 2019 af delc

1. Jeg tror at du ikke helt har forstået hvad argmin endelig gør. Den finder en teta i din parameterrum der minimerer argumentet. Da den første led er uafhængig i teta. For eksemple: Find x der minimerer f(x) = x^2 + C, hvor C er en konstant. Tror du at C er nødvenligt for at find sådan en x? Betyder det ikke at for at find sådan en x behøver du kun blot at se på x^2 termen? Dette betyder argmin f(x) = argmin x^2.

2. Den afhænger af teta. Og så er den ikke lig med 0, med mindre

3. Hvordan minimerer du i OLS? (Hint: differenterer den i forhold til teta og sæt den afledte lig med 0. Dette kaldes også for normal ligningen).

Svar #18

07. december 2019 af bokaj123

ahh, jamen det kan jeg godt se nu du siger det :) det eneste led der afhænger af teta (ikke teta hat som vel bare er et estimat) er led 2 og 4. takker for tålmodigheden ;)

Svar #19

07. december 2019 af bokaj123

så til at starte med burde jeg bare se på hvilke led indeholder teta og så finde den afledte og de led, men er det så ikke det samme som at finde den partielt afledte?